【第6回】富士通次世代コンピューティングセミナー

- 日時

- 2024年03月04日(月)14:00-16:00

- 講演

- 14:00-15:00「大規模言語モデル(LLM)の学習を支える分散学習技術」

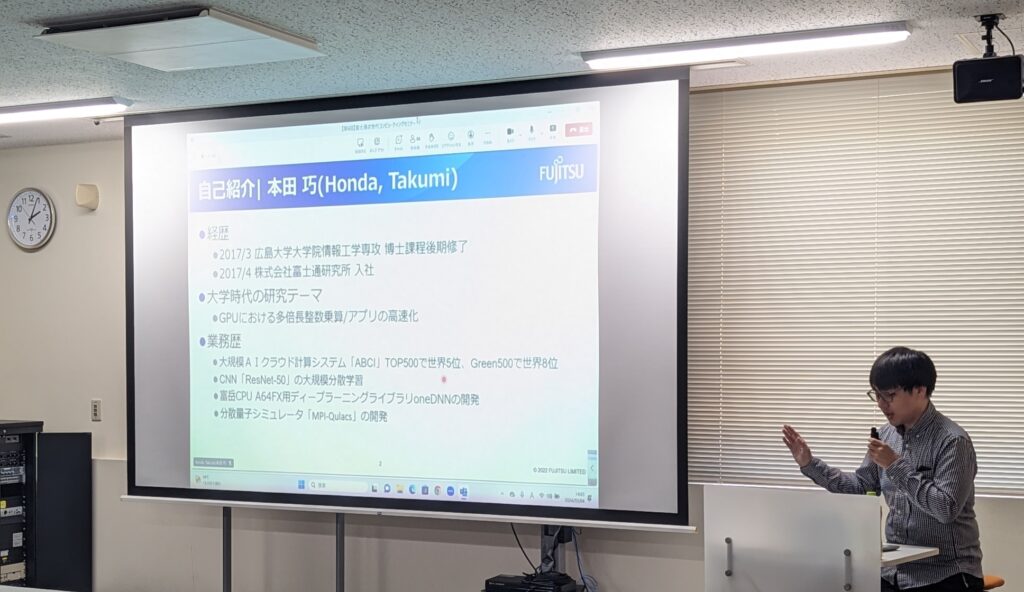

- 本田 巧/Honda Takumi(富士通株式会社コンピューティング研究所 シニアリサーチマネージャー)

- 大規模言語モデル(Large Language Model)に焦点を当て、学習の高速化のための技術について解説します。近年の言語モデルの基盤となっているTransformerアーキテクチャ、大規模言語モデルが開発される背景にあるScaling Lawついて紹介します。さらに、有名な大規模言語モデルであるGPT-3を例に、大規模言語モデルの学習に必要な3次元の並列化手法を説明します。また、メモリ使用量削減技術や高速化技術についても触れます。この講演を通じて、大規模言語モデルの分散学習技術について理解を深めることができます。

- 本田 巧/Honda Takumi(富士通株式会社コンピューティング研究所 シニアリサーチマネージャー)

- 15:00-16:00「近似コンピューティングで計算機システムの高速化と省電力化を両立しよう!!」

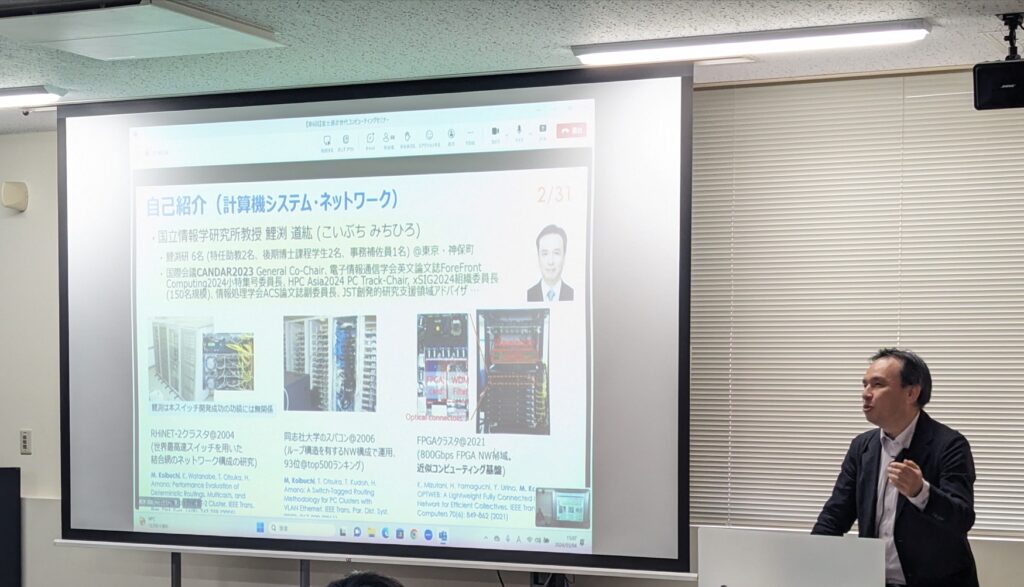

- 鯉渕 道紘/Koibuchi Michihiro(国立情報学研究所/総合研究大学院大学 教授)

- 計算機システム・ネットワークの設計では、一般的に高速化と省電力化はトレードオフの関係にあるため、両立させることが難しい。本講演では、「精度(近似)」という軸を導入、調整することで、このトレードオフの解消を目指す近似コンピュータの現状と展望を述べる。近似コンピューティングの本質は、アプリケーションから要求される「正確さ」とシステムが供給する「正確さ」のギャップを埋めてコンピューティングの性能・エネルギー効率化を達成することである。具体的に、コンピュータの構成要素であるプロセッサ、メモリ、ネットワークに関する例(講演者の研究を含)を用いて、計算機システムの高速化と省電力化の可能性を描く。

- 鯉渕 道紘/Koibuchi Michihiro(国立情報学研究所/総合研究大学院大学 教授)

- 14:00-15:00「大規模言語モデル(LLM)の学習を支える分散学習技術」

- 場所(ハイブリッド開催)

- オフライン:広島大学 情報メディア教育研究センター本館2階 セミナー室1, 2, 3

- オンライン:Microsoft Teams会議

- 参加方法

- こちらの参加登録フォームよりお申し込みください

- 学内からの参加は基本的に登録不要です(オンライン参加でURLがわからない場合はご登録ください)

現地約20名+オンライン約40名の約60名に参加していただきました。